9月4日,2024外滩大会在上海开幕的前一天,一条人工智能相关的新闻冲上网络热搜:外滩大会全球Deepfake(深度伪造技术)挑战赛的参赛选手之一,中国科学院的“95后”女性算法工程师张欣怡宣布,已将近期参加挑战赛的AI模型向全球开源,希望以此降低Deefake对抗的使用门槛,援助Deepfake受害者,守护真实世界。

结合近期韩国互联网爆出的Deepfake女性受害事件,张欣怡的做法在网络刷屏。人工智能的应用与担忧再次成为饱受集体关注的公共性事件。

探寻2024外滩大会,AI等未来技术不再是空想,大量的落地应用已经成为展会主流。向外界展示如何用好AI、管好AI是本届外滩大会和过去最大的不同。无论想与不想,安全与风险,人工智能都在迅速地改变现实世界。

AI应用势如破竹

多年前,金庸先生在接受采访时透露过他的文学创作门道:先构思好人物性格,然后再按设定好的人物性格去编情节。这可能代表了许多人类作家的文学创作思路。

金庸先生肯定不会想到,如今机器也是循着同样的路径创作作品的(虽然我们还不能确定机器的创作是不是真的称得上作品)。在本届外滩大会的现场,有关辅助创作的大模型产品层出不穷,有的定位于帮写作者梳理写作线索和思路,生成思维导图;有的定位于帮写作者完成扩写,丰富文章内容;甚至还有工具可以帮助创作者将刚刚写好的故事生成视频,顷刻之间,想法已经转化成多种形态的作品。

不仅是模仿人、替代人完成一部分工作,人工智能甚至可以超越人类,完成一些过去很难实现的任务。2020年,麻省理工学院的研究人员宣布发现了一种新型抗生素,能够消灭此前对所有已知抗生素都有耐药性的细菌菌株。传统上,一种新药的研发需要研究人员从上千种潜在分子着手,通过不断试错,筛选出少量候选分子。麻省理工学院则另辟蹊径,让人工智能参与筛选分子数据库,最终在6.1万个分子中找到一个符合标准的,研究人员把它命名为海利霉素(Halicin)。

近两三年,人工智能快速发展,人们大胆预测:它正在“接管药物研发”“改变好莱坞讲故事的方式”,并可能“改变科学本身”。它的一些能力甚至已经超越了人类的理解。

虽说预期有无限可能,但人工智能究竟能做什么、不能做什么,我们依然没有完全确定。只是业界发现,越大的模型、越多的数据,就有可能让人工智能更加智能。业界把它称作“规模法则”(scaling laws),也有人更具象化地说成是“暴力美学”。

我们也还没有完全确定,现有的千行百业如何嫁接人工智能的魔力。到目前为止,人工智能只在一些特定领域显示了超凡的能力,比如人脸识别、文字翻译、内容生成……但是人工智能模型不擅长逻辑和推理,因而也不清楚自己的输出是否符合人类需求,它依赖人类来界定它所解决的问题。就像发现海利霉素,人工智能需要人类为目标分子设立标准:能够杀死致病菌、与现有抗生素不同、无毒。

也许更多模型参数、更大数据量能改善人工智能的逻辑和推理,使它涌现出更高智能。但“规模法则”是否有边界?起码现在看来,人工智能只是精心制作的代码,没有生命或自主能力。人工智能的革命性能力仍然依赖于人类的判断。

2024外滩大会上展示的一些AI辅助办公工具。

2024外滩大会上展示的一些AI辅助办公工具。

数据问题仍需解决

人类是如何学习的?这个问题很难有一个简单的回答。我们耳濡目染,我们归纳推理,我们做科学实验,我们甚至去天马行空地冥想。人类学习不依赖于某种单一途径。

人工智能的学习方法和人类迥异。当前人工智能普遍运用一种叫作“深度学习”的方法。在这种学习方法中,人工智能依据数学和统计学方法处理大量数据,从中获得某种规律。数据是人工智能的食粮,数量越多、质量越高,就意味着人工智能可能有越优良的表现。谷歌和Meta的人工智能模型已经接受了超过1万亿个单词的训练。要知道,维基百科的总单词量只有约40亿个。

在外滩大会的提前探访中,不少AI企业都提到了数据的问题:高质量数据的生成速度远低于人工智能大模型的需求,数据短缺问题已初现端倪。研究机构Epoch AI预计,可用于训练的高质量文本可能在2028年前耗尽。在中文世界,数据问题更加棘手。阿里研究院5月发布的《大模型训练数据白皮书》显示,互联网上中文语料和英文语料占比存在显著差异:在全球网站中,英文占比高达59.8%,而中文仅占1.3%。在业界,数据短缺问题也被称为“数据墙”。 如何处理这堵墙迫在眉睫。

一种方法是注重数据质量而非数量。人工智能企业对数据进行过滤和排序,以最大限度地提高模型的学习效率。关于世界的真实信息显然很重要,逻辑推理也很重要。因此,学术教科书(而不是未经筛选的互联网数据)就显得尤为珍贵。

另一种方法是使用合成数据,这些数据由机器创建,因此是无限的。谷歌子公司DeepMind制作的围棋模型AlphaGo Zero就是一个很好的例子。AlphaGo Zero没有使用任何已有棋谱数据,而是通过自我对弈490万次来学习围棋,并记录下获胜的策略。这种“强化学习”通过模拟大量可能的应对方法,并选择胜算最大的,教会模型如何应对对手的棋步。

就像深藏地底的石油驱动了工业进步,散布在互联网和人类文本中的数据驱动了人工智能不断升级。但在不久的未来,石油、数据终将枯竭,我们需要寻找新的、可再生的替代品。

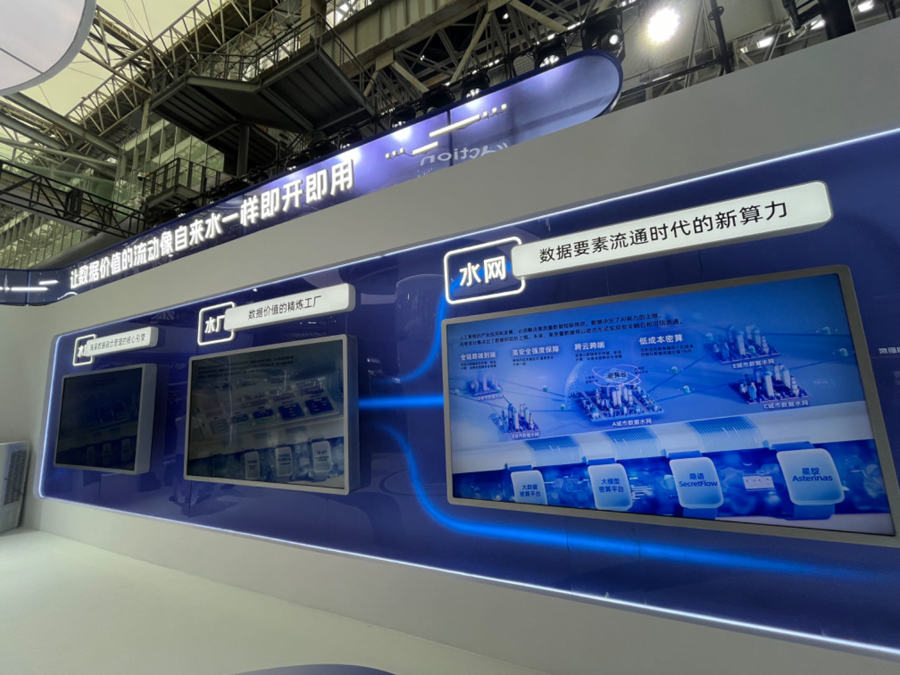

数据在未来会变成像石油一样的宝贵资源。

数据在未来会变成像石油一样的宝贵资源。

安全担忧从未停止

一个摆在人们面前的问题是,随着AI落地应用的普及,越来越多由AI引发的伦理安全风险也随之暴露。

8月底,一场对Deepfake滥用的声讨席卷韩国互联网。事件的起因是有部分韩国网民在社交媒体上传播用Deepfake技术制造的“换头”色情图片、影像,被涉及对象有女明星、女学生,甚至有未成年女孩。

Deepfake“换头”,通俗来说就是使用人工智能生成技术,将不同个人的声音、面部特征和身体动作拼接起来,合成虚构的图像或视频。

这些用AI技术合成的影像、视频几乎以假乱真,被用于制作和传播不仅严重侵犯了个人隐私权和名誉权,更对涉及女性心理造成了深刻的负面影响。

人们不得不承认,客观上,AI技术的快速发展加剧了犯罪手段的更新。今年年初,国外“文生视频”应用软件Sora曾刷屏互联网。当时即有人提出,人工智能生成技术发展太快,内容很容易不受控制,被应用于黄色、犯罪产业。

考虑到内容生产上的风险和成本控制,截至目前,Sora模型尚未正式向公众免费开放。OpenAI选择向一组精选的“红队成员”开放Sora,这些成员是专门评估AI模型风险和识别潜在问题的专家,他们将从各个角度“对抗性”地测试这个模型。

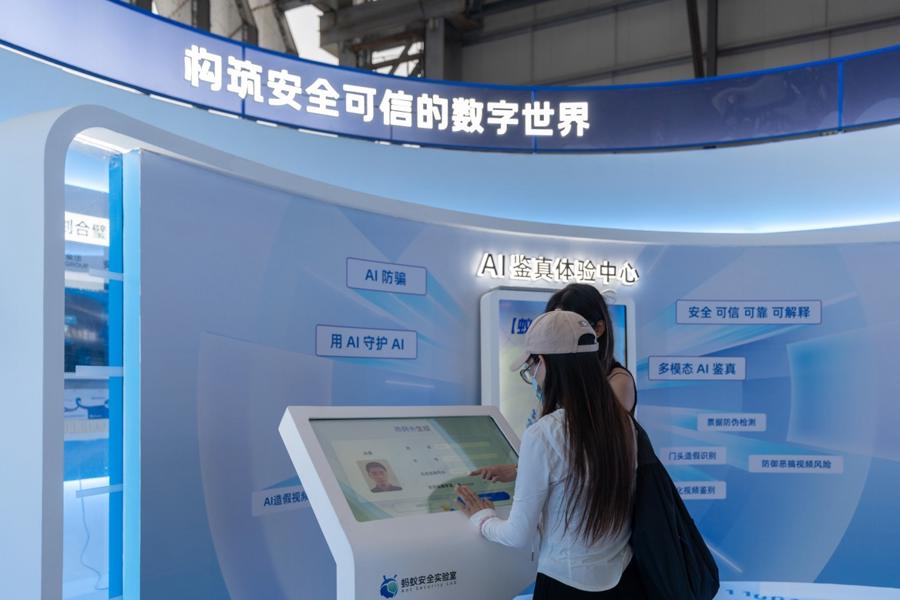

为了解决这些AI内容生成安全问题,业界已经开始了探索。在本次外滩大会的前沿科技展区,专门设立了一所未来安全实验室,囊括了多个国内互联网安全、AI安全和检测的前沿产品,其中就包括了蚂蚁集团蚁天鉴推出的“AI鉴真”解决方案。参观者可以现场对AI生产的图片、视频、音频进行鉴定。

蚂蚁大安全的一位工作人员告诉记者,目前大部分利用AI生成技术进行的违法活动都是批量化生产,单个目标的伪造成本不会很高,通过对抗模型的构建,一般都可以甄别其真伪。尤其在图像识别领域,准确率甚至可达99.99%。

此外,本次外滩大会首次举办的AI创新赛还专门设立了全球Deepfake挑战赛,邀请来自海外高校的技术团队,聚焦国际最热的安全、欺诈风险问题,探索更多Deepfake对抗技术。

外滩大会设立的“AI鉴真”展台

外滩大会设立的“AI鉴真”展台

AI已经无处不在

尽管人们对AI还不能完全掌控,但市场对AI应用的热情并不会就此停下。

可能在不知不觉中,普通人的生活就已被AI产品包围。除了前文提到的儿童手表,AI大模型可以嵌入一切智能设备,例如智能手机、智能音箱、智能家电等。再大一点,内置了AI大模型的智能汽车也已经问市多时。

就拿AI上车来说,目前已有蔚来、理想、小米、智己等多家车企宣布将AI大模型嵌入汽车的智能座舱,以实现用户和车机的智能语音互动。更重要的是,AI技术突破正在帮助全球智能驾驶研发提速,无人车正离人类越来越近。

近期武汉的“无人出租车”爆火后,其“无人驾驶”技术曾受到多方质疑。很多人猜测,“无人出租车”之所以能够无人驾驶,是有驾驶员在线上远程控制,全靠真人远程代驾。实际上,“萝卜快跑”出租车虽然配备了远程操控员,但操控员并不会直接干预汽车的驾驶,只会在极端情况发生时对车辆进行接管,而且一人负责监测多台汽车。商业出租车能够实现无人驾驶,正是因为AI技术的赋能,让车机能够实时处理来自传感器的数据,识别道路状况,做出驾驶决策,如加速、减速、转向等。

这就是一则AI影响人类生活的直观案例。技术的突飞猛进正在改变车主的生活,甚至司机的生活。不少人可能会因此失业,但新的就业机会也在AI产业浪潮中不断涌现。

在上海临港,一批过去从事网约车行当的司机已经上岗无人车安全员。赛可智能测试车队的一名安全测试员告诉记者,在测试车队上班,一天8到10个小时,工资和过去开网约车差不多,都能过万元,但是工作量确实小了不少。这种新的生活方式正在逐渐被大众所接受。

华人站华人新闻,华人中文网

华人站华人新闻,华人中文网